摘要

· AMD ROCm? 7 通过显著的性能提升、分布式推理、企业级解决方案以及对 Radeon 和 Windows 更广泛的支持,携手开源社区推动 AI 向前发展。

· AMD Developer Cloud 提供对 AMD Instinct MI系列 GPU 的即时访问,无需本地硬件,配备预配置的开发环境和免费额度,助力 AI 开发与部署的高效推进。

· 不断扩展的 AMD AI 生态系统展示了 ROCm 在实际场景中的应用,推动可扩展、开放的 AI 创新。

开发者优先。这是我们在构建 ROCm? 7 和 AMD Developer Cloud 时秉持的核心理念。因为在 AMD,我们不仅是在打造 AI 工具——我们更是在为开发者打造这些工具。

无论你是正在探索首个大语言模型想法的研究生,调整下一代注意力机制的科研人员,还是在超大规模环境中推进生产任务的团队,我们的目标都是让你的工作变得更轻松、更高效、更出色。ROCm面向所有人,适用于各种场景。

在过去的一年中,我们将重点转向提升在关键模型和框架上的推理与训练能力,并持续扩大客户基础。我们对开发者支持的承诺带来了更完善的开箱即用体验、更简化的配置流程,以及更高水平的社区参与。因此,客户正以前所未有的速度部署 AI 能力,这也促使我们加快新功能的发布节奏。Llama 4、Gemma 3 和 Deepseek 等主流模型现已获得首日支持,我们与开源社区的合作也达到前所未有的紧密程度,进一步体现了我们在履行推动开放且创新的 AI 生态系统的承诺。

在 Advancing AI 2025 上,我们分享了一个愿景。这不仅关乎性能图表或参数指标,更关乎易用性与可扩展性。我们希望让任何拥有 GitHub 账户的人都能使用 MI系列 级别的 GPU;希望通过简单的 pip install 即可安装 ROCm;希望用户能在几分钟内从零开始运行 Triton kernel Notebook。

借助 ROCm 7 和 AMD Developer Cloud,这一愿景已成为现实。它开放、无障碍,并为你以自己的方式构建 AI 未来做好了准备。

让我们深入了解。

ROCm 7:加速开发者赋能与大规模 AI 性能提升

借助 ROCm 7.0,AMD 正在从算法到基础设施的各个层面加速 AI 创新,为软件栈重新带来真正的竞争与开放。ROCm 7.0 旨在满足生成式 AI 和高性能计算(HPC)工作负载不断增长的需求,同时通过提升易用性、效率以及活跃的社区协作,重塑开发者体验。

我们很高兴宣布,具备多项新功能与增强特性的 ROCm 7 将于 2025 年第三季度全面开放使用。以下是即将推出的一些重要特性预览:

ROCm 在 Radeon 和 Windows 上的支持:ROCm 7 将使用体验扩展至云端之外,支持在 锐龙笔记本和工作站上的开发,实现从云端到终端的一致创新。预计自 2025 年下半年起,ROCm 将集成于主流发行版本中,将 Windows 打造为一流且全面支持的操作系统,确保在家庭和企业环境中的跨平台能力和高效性能。

图 1 展示了 ROCm 7 在 AI 推理性能方面的显著提升¹。

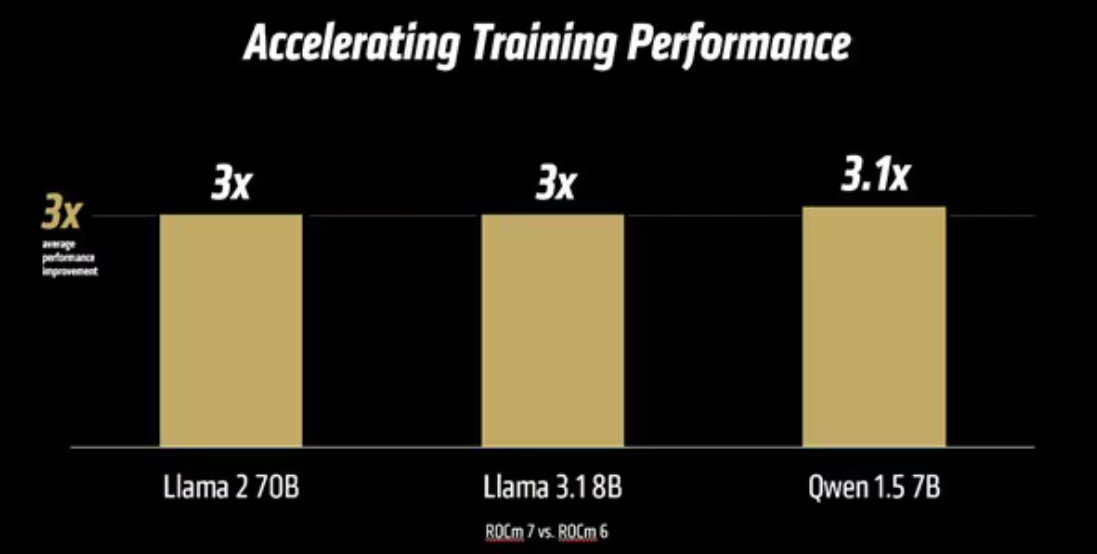

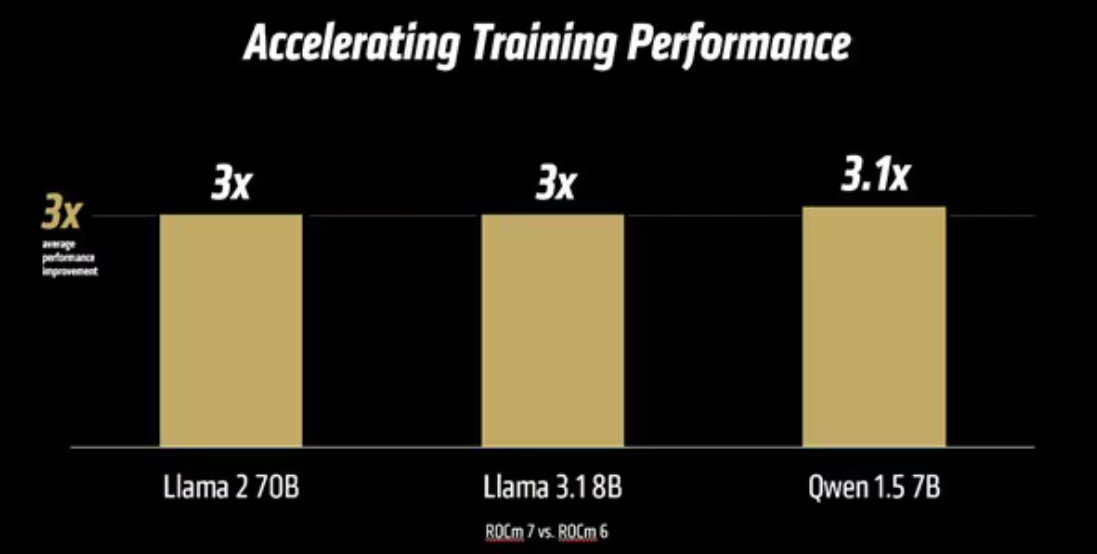

图 2 显示在 AI 训练中,ROCm 7 相较于 ROCm 6 平均实现了 3 倍的性能提升²。

合作共建开放 AI 生态系统

重点 ROCm 生态合作伙伴:

这项深度的合作伙伴协作确保开发者能够使用业界领先的工具,享受持续的性能提升,并在开放的环境中快速迭代和部署。

AMD Developer Cloud:无障碍接入世界级计算资源

作为对 ROCm 7 的补充,AMD Developer Cloud 现已广泛面向全球开发者和开源社区开放。该全托管环境提供即时访问 AMD Instinct MI系列 GPU 的能力,无需任何硬件投资或本地配置。

AMD Developer Cloud 亮点:

无论您是在微调大语言模型(LLM)、进行推理性能基准测试,还是构建可扩展的推理架构,AMD Developer Cloud 都为您提供即刻启动所需的工具与灵活性,并实现无限扩展。

不断壮大的 AI 生态系统

AMD Developer Cloud 的独特之处不仅在于其基础设施,更在于支持并伴随其发展的充满活力的生态系统。

Developer Cloud 生态亮点:

这些合作表明,AMD Developer Cloud 不仅仅是一个计算平台,更是推动下一代 AI 创新的起点。从企业应用到开源实验,日益壮大的 AMD 合作伙伴生态系统正在积极塑造面向每一位云用户的工具和服务。

硬件配置

1P AMD EPYC? 9534 CPU 服务器,配备 8 个 AMD Instinct? MI系列(192GB,750W)GPU,Supermicro AS-8125GS-TNMR2,NPS1(每个插槽 1 个 NUMA),1.5 TiB 内存(24 条 DIMM,4800 MT/s,64 GiB/DIMM),4 个 3.49TB Micron 7450 存储,BIOS 版本:1.8。

软件配置

Ubuntu 22.04 LTS,Linux 内核 5.15.0-119-generic。

Qwen 72B 和 Llama 3.1-70B:ROCm 7.0 预览版软件,PyTorch 2.7.0。

Deepseek R-1:ROCm 7.0 预览版,SGLang 0.4.6,PyTorch 2.6.0。

对比版本:

Qwen 72B 和 Llama 3.1-70B:ROCm 6.x GA 版本软件,PyTorch 2.7.0 和 2.1.1。

Deepseek R-1:ROCm 6.x GA 版本软件,SGLang 0.4.1,PyTorch 2.5.0。

服务器配置可能有所不同,导致测试结果存在差异。性能表现会因配置、软件版本、vLLM 版本以及是否使用最新驱动和优化措施而异。

硬件配置

1P AMD EPYC? 9454 CPU,8 个 AMD Instinct MI系列GPU(192GB,750W)GPU,American Megatrends International LLC BIOS 版本:1.8。

软件配置

Ubuntu 22.04 LTS,Linux 内核 5.15.0-70-generic。

ROCm 7.0,Megatron-LM,PyTorch 2.7.0。

对比版本:

ROCm 6.0 公共发布版本软件,Megatron-LM 代码分支:

hanl/disable_te_llama2 用于 Llama 2-7B,

guihong_dev 用于 Llama 2-70B,

renwuli/disable_te_qwen1.5 用于 Qwen1.5-14B,

PyTorch 2.2。

服务器配置可能有所不同,导致测试结果存在差异。性能表现会因配置、软件版本、vLLM 版本以及是否使用最新驱动和优化措施而异。